在当今时代,人工智能(AI)正以前所未有的速度改变着我们的生活、工作和学习方式。然而,在这股技术潮流中,总有一些犯罪分子企图利用AI的便利特性进行非法活动。接下来,就一起揭秘他们那些不可告人的手段——犯罪分子使用AI的五种方式。

大多数罪犯不是生活在某个黑暗的巢穴里,也不是在密谋,他们中的大多数都是普通人,他们进行定期活动,这些活动也需要生产力。

去年的风云变幻,目睹了WormGPT这一传奇AI语言模型的崛起与陨落。这一模型以开源技术为基石,通过海量恶意软件数据的锤炼,锻造出强大的能力。然而,它的目标并非用于正义之事,而是助长了黑客们的嚣张气焰,没有道德的束缚,也没有规则的制约。

但去年夏天,它的创建者宣布,在它开始引起媒体关注后,他们将关闭该模型。从那时起,网络犯罪分子大多停止开发自己的人工智能模型。取而代之的是,他们选择了使用可靠工作的现有工具的技巧。

对于任何新技术来说,这是因为犯罪分子想要轻松的生活和快速的收益,要想抵消与采用它相关的未知风险(例如,更高的被抓的风险),它必须比他们目前使用的更好,并带来更高的回报。

以下是犯罪分子现在使用 AI 的五种方式。

网络钓鱼

苏黎世联邦理工学院(ETH Zurich)的人工智能安全研究员米斯拉夫·巴卢诺维奇(Mislav Balunović)说,目前犯罪分子中生成式人工智能的最大用例是网络钓鱼,它涉及试图诱骗人们泄露可用于恶意目的的敏感信息。研究人员发现,ChatGPT的兴起伴随着网络钓鱼电子邮件数量的大幅增加。

GoMail Pro等垃圾邮件生成服务已将ChatGPT集成到其中,这使得犯罪用户能够翻译或改进发送给受害者的消息。

OpenAI的政策限制人们将他们的产品用于非法活动,但这在实践中很难监管,因为许多听起来无辜的提示也可能被用于恶意目的。OpenAI表示,它使用人工审查员和自动化系统的组合来识别和执行滥用其模型的行为,如果用户违反公司的政策,它会发出警告,暂时暂停和禁令。

OpenAI的一位发言人表示:“我们认真对待我们产品的安全性,并根据人们使用我们产品的方式不断改进我们的安全措施,我们一直在努力使我们的模型更安全、更强大,防止滥用和越狱,同时保持模型的实用性和任务性能。”

在2月份的一份报告中,OpenAI发布已经关闭了五个与国家附属恶意行为者有关的账户。

以前,所谓的尼日利亚王子骗局,即有人向受害者承诺一大笔钱以换取少量预付款,相对容易被发现,因为消息中的英语笨拙且充斥着语法错误,语言模型允许诈骗者生成听起来像母语人士会写的东西的消息。说英语的人过去对非英语的相对安全,因为你可以发现他们的信息现在已经不是这样了。

在人工智能翻译技术飞速发展的今天,世界各地的犯罪集团竟然也能从中获益,他们之间的沟通交流变得更加畅通无阻。这原本是一项旨在消除语言障碍、促进全球交流的技术进步,却不料竟为犯罪分子提供了可乘之机。

如今,这些犯罪团伙可以更加轻易地协调跨国的大规模行动,将黑手伸向其他国家的无辜民众。他们利用先进的人工智能翻译工具,轻松破解语言障碍,使得跨国犯罪活动变得愈发猖獗和难以防范。面对这一风险,我们必须保持高度警惕,加强跨国执法合作,共同打击这些犯罪团伙的嚣张气焰。

Deepfake音频诈骗

生成式AI技术的飞速发展,将deepfake开发推向了一个崭新的高度。如今,通过这项技术,能够创造出外观和声音都几乎完美无瑕的合成图像、视频和音频,逼真程度达到了前所未有的境地。

人们在社交媒体平台上炫耀他们的深度伪造组合,并以每张图片10美元或每分钟500美元的价格出售他们的服务。最受犯罪分子欢迎深度伪造的人之一是埃隆·马斯克(Elon Musk)。

虽然深度伪造视频的制作仍然很复杂,而且更容易被人类发现,但音频深度伪造的情况并非如此。它们的制作成本很低,只需要几秒钟的人的声音,例如从社交媒体上取就能产生一些令人信服的东西。

在美国,曾发生过一些备受瞩目的案件,人们接到亲人打来的电话,说他们被绑架了,并要求释放钱财,结果来电者却被证明是使用深度伪造录音的骗子。

绕过身份检查

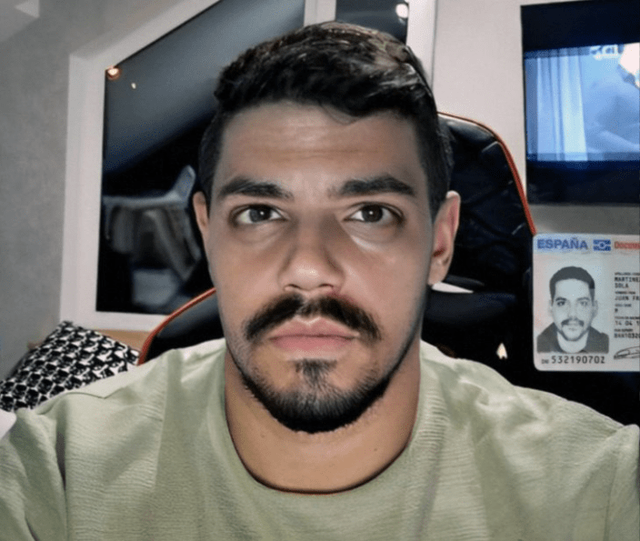

犯罪分子使用深度伪造的另一种方式是绕过验证系统。银行和加密货币交易所使用这些系统来验证他们的客户是否是真实的人。他们要求新用户在相机前拍摄自己拿着实体身份证件的照片。但犯罪分子已经开始在社交媒体平台上销售应用程序,让人们可以绕过这些要求。

他们的工作方式是提供虚假或被盗的身份证件,并在真人的脸上强加一张深度伪造的图像,以欺骗 Android 手机摄像头上的验证系统。他们使用的技术类似于Instagram滤镜,将别人的脸换成你自己的脸。

图:身份证被盗和犯罪分子使用换脸技术绕过身份验证系统的例子。

越狱即服务

如果向人工智能系统询问如何制造炸弹,会得到怎样的答案?可能会失望地发现,大多数人工智能系统并不会给你提供任何有用的信息。这背后究竟隐藏着什么秘密呢?

其实,原因在于人工智能公司已经采取了一系列严格的保护措施,以确保他们的模型不会输出任何有害或危险的信息。这样的举措,无疑为人工智能的安全使用筑起了一道坚实的屏障。

然而,对于那些企图利用人工智能技术从事非法活动的网络犯罪分子来说,情况却并不那么乐观。他们发现,在没有这些保护措施的情况下,自行构建人工智能模型既昂贵又耗时,而且技术难度也相当大。于是,他们开始寻找新的途径来满足自己的需求。这时,一种名为“越狱即服务”的新趋势应运而生。这种服务为那些想要绕过人工智能安全限制的网络犯罪分子提供了便利,使得他们能够轻松地获取到所需的信息。这无疑给人工智能的安全使用带来了新的挑战。

大多数模型都有关于如何使用它们的规则。越狱允许用户操纵 AI 系统生成违反这些策略的输出,例如,为勒索软件编写代码或生成可用于诈骗电子邮件的文本。

EscapeGPT 和 BlackhatGPT 等服务提供对语言模型 API 和频繁更新的越狱提示的匿名访问。为了反击这个不断发展的家庭手工业,OpenAI和谷歌等人工智能公司经常不得不堵住可能允许其模型被滥用的安全漏洞。

越狱服务使用不同的技巧来突破安全机制,例如提出假设性问题或用外语提问。人工智能公司试图防止其模型行为不端,而恶意行为者则提出了更具创造性的越狱提示,这两者之间一直存在着猫捉老鼠的游戏。

人肉搜索和监视

AI 语言模型不仅是网络钓鱼的完美工具,也是人肉搜索(在线泄露某人的私人身份信息)的完美工具。这是因为人工智能语言模型是在大量互联网数据(包括个人数据)上训练的,并且可以推断出某人可能位于何处。

作为其工作原理的一个例子,可以要求聊天机器人假装是有剖析经验的私家侦探。然后,可以让它分析受害者写的文本,并从文本中的小线索中推断个人信息——例如,根据他们上高中的时间推断他们的年龄,或者根据他们在通勤途中提到的地标来推断他们的居住地。互联网上关于他们的信息越多,他们就越容易被识别。

一个研究小组去年年底发现,GPT-4、Llama 2 和 Claude 等大型语言模型能够推断出敏感信息,例如人们的种族、位置和职业,纯粹来自与聊天机器人的日常对话。从理论上讲,任何有权访问这些模型的人都可以以这种方式使用它们。自从他们的论文发表以来,已经出现了利用语言模型这一特性的新服务。

尽管这些服务的存在并不直接等同于犯罪活动的猖獗,但它们的出现无疑揭示了恶意行为者可能掌握的新技术手段。

评论列表 (0条)